リスク評価で社会に受け入れられるAIを|Deloitte AI Institute Spirits #3 ブックマークが追加されました

いまや人類の未来を照らす存在であることが確実視されるAI技術。ただし、やみくもにAIを導入するだけでは、その強大なパワーがかえって当事者や社会の不利益につながる可能性もはらんでいます。新しい技術であるがゆえの手探り状態を経て、今、必要とされているのは、「社会に受け入れられるAI」であることを客観的に検証するためのAIガバナンスの枠組みです。

デロイト トーマツ グループの Deloitte AI Institute には、人とAIが協調する社会「The Age of With」の実現に向けて、日夜精魂を傾けつづける先駆者たち「AI Spirits」が多数在籍しています。このインタビューシリーズでは、そんなデロイト トーマツの「AI Spirits」1人ひとりに焦点を当て、AI導入の最前線とその魅力についてお伝えします。

第3回である今回は、コンサルタントとして現場で顧客と向き合いながら、東京大学で客員研究員としてAIガバナンスについての研究も進めているデロイト トーマツ コンサルティング Project Oneユニットの松本に話を聞きました。

AIの戦略的活用とガバナンスは表裏一体

--まずは自己紹介をお願いします。

デロイト トーマツ コンサルティングProject Oneユニットの松本敬史です。デロイト トーマツのコンサルティングプロジェクトにAIガバナンスのスペシャリストとして関与する一方、産官学の共同研究にも携わっており、東京大学未来ビジョン研究センターで、客員研究員としてAIガバナンスについて研究活動をしています。他にも日本ディープラーニング協会、GPAI(Global Partnership on AI)などにも参加し、AIに関する研究活動を広く行っています。

--これまでどのような経験を積んできましたか?

大学卒業後、ソフトウェアエンジニアを経験したのち、8年前から監査法人トーマツに転職して、システム監査、内部監査、税務のアドバイザリーに関わってきました。そして、これらのプロジェクトで税金の予測などにAIを利用したのがきっかけで、機械学習を学ぶようになりました。

Deloitte AI Instituteの活動は、AIの戦略的活用とAIガバナンスが2本柱となっていますが、私は主にAIガバナンスに注力する立場で、先ほど述べた外部機関にも参加しながら研究を進めています。そして2022年7月からは、デロイト トーマツ コンサルティングに移籍して、AIガバナンスの研究成果の社会実装を進めています。

--AIガバナンスに取り組むとき、重要な視点は何でしょう

ここ1年、毎週のように新しいお客様から問い合わせがくるほど、AIガバナンスはホットトピックになっています。AIガバナンスが問題にするのは、公平性や説明可能性など、社会倫理的テーマですが、実際には「何のためにAIを使いたいのか」というビジネス戦略がクリアでなければ、あるべきガバナンスの姿は見えてきません。AIの戦略的活用とAIガバナンスは表裏一体で考える必要があります。

AIがこれまでのITシステムと異なるのは、不確実性をはらんでいるところ

--現状のAIガバナンスの課題としては、どのようなものがありますか

AIがこれまでのITシステムと異なるのは、不確実性をはらんでいるところです。そのために起こる問題として、AIが不当に誰かの不利益になる判断をしてしまう公平性の問題、判断の経緯がブラックボックス化してしまう説明可能性の問題、小さなノイズや変化に過剰に反応してしまう頑健性の問題などがあります。

また「データドリフト」と呼ばれる問題もあります。これは、学習のときとデータの傾向が変化した場合にAIの精度が下がってしまうことを指します。例えば、人材採用のためのAIであれば、学習データに外国人の合格者が少ししか存在しない場合、外国人の応募者が増えてきたときに、AIが適切な結果を出せないケースなどがあります。この場合は、新たなデータでAIを再学習するか、外国人の方については判断を人間が行うなど、運用でカバーする必要があります。

さらに「コンセプトドリフト」と呼ばれる問題もあります。人材採用AIの例であれば、ビジネスの方向性が変わり求める人材が変化した場合などに、これまでの採用AIの結果がフィットしなくなることなどを指します。このようなときは、新たな学習データをどのように蓄積していくかを考えるとともに、こちらも既存のAIを適用できない部分は人間が担当するなど、AIと人間が協業して調整していく必要があります。

AIの法規制はルールベースではなくゴールベース

--法律や規制の動きもあるようですね

ここ5年ほどOECDやEUなどでの議論が進み、AIについてのポリシーやガイドラインが策定されています。日本でも総務省から「AI利活用ガイドライン(リンク先は総務省のサイトとなります)」が公開されました。

ただ海外では、より強制力の高い法規制も実装されようとしています。ヨーロッパでは包括的なAI規制やAI条約などを制定する方向で進んでいます。一方アメリカでは、州ごと、都市ごとにユースケース単位で規制をかける動きがトレンドとなっており、例えばニューヨーク市では、人材採用のAIを使う際、必ず第三者からバイアスの評価を受けることが市の条例で定められようとしています。

このような流れは日本国内にもやって来る可能性がありますし、グローバルに展開する日本企業にとっては直接的に影響するため、注視しておく必要があります。

--規制はどのような形で課せられるのでしょうか

たとえば公平性について言えば、データには常に何らかのバイアス(偏り)が含まれてしまうものです。バイアスは「度合い」の問題なので、「これは良くてこれはダメ」と明確に決められるものではありません。そこでAI規制などでは、バイアスの有無自体ではなく、その評価プロセスの明確化を求めるのが一般的です。

例えば先のニューヨーク市の場合は、「(採用結果に)特定の項目についてバイアスがあってはいけない」という形ではなく、「結果に含まれるバイアスを社会が受容できるかどうか第三者によって検証する」ことが規定されています。

また、経済産業省では、2020年の報告書(*)のなかでAIにおけるルールについて「ルールベースの法規制ではなくゴールベースの法規制にするのが望ましい」という見解を明らかにしています。

* 「GOVERNANCE INNOVATION: Society5.0の実現に向けた法とアーキテクチャのリ・デザイン」(外部サイト)

例えば「赤信号は渡ってはいけません」といった個別の事例に対するルールではなく、「公平性を確保する」とか「説明責任を果たす」などのゴールを定めるということです。そのためのポリシーをどう定義し、具体的にどう実現するかは、各企業が考えて行くことになります。

テクノロジーだけではリスクを抑えられない

--松本さんはAIガバナンスにどのように取り組んでいますか?

AIガバナンスに関しては、実際のケースで考えることを重視しています。私はデロイト トーマツと東京大学の両方で活動しており、アカデミックな最新の議論や論文に触れる機会と、実際の現場の情報に触れる機会の両方が持てることは、AIガバナンスについて考える上で大きな意味があると思っています。

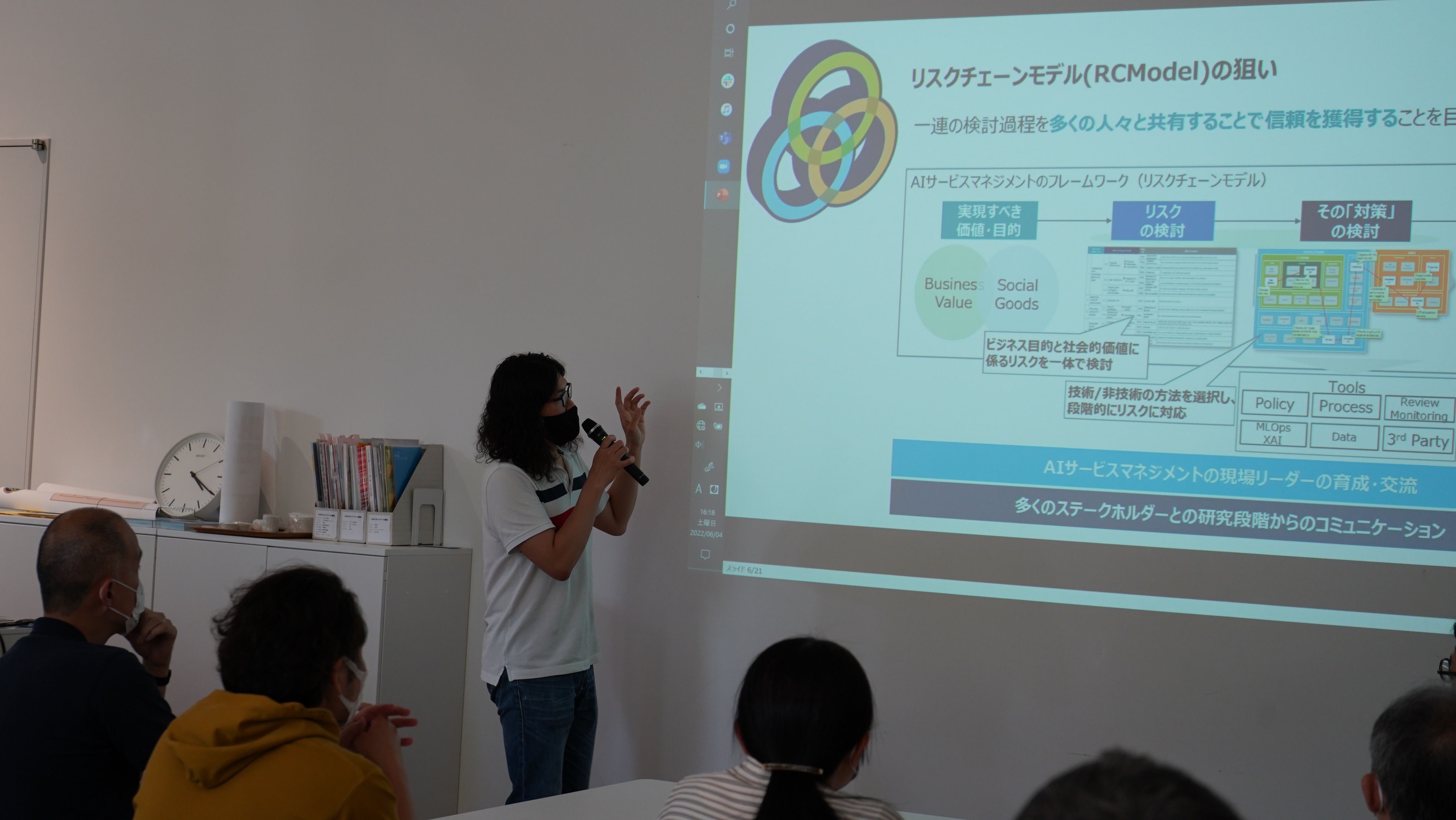

いま注力しているのはAIガバナンスを実現するためのリスクチェーンモデル(外部リンク)です。これはAIに関するリスクを検討するためのフレームワークになっています。

--リスクチェーンモデルとはどういったものですか?

AIサービスが実現したい価値、目的は何かという部分から考え、リスクを導き出し、重要度ごとにどういった対策をとるべきか検討するための枠組みです。AIモデル自体が不確実性をはらむものなので、AIモデルだけではリスクを抑え続けることはできません。そこでデータをどうやって収集するのか、どう学習させるのか、どういう情報で出力するのか、AIサービスを提供する人間の行動規範、運用方法、さらにはサービスを使う側の利用者まで範囲を広げてリスク要因を考えて行きます。

このようにリスク要因には技術と非技術が混じり、さまざまな要素が結びついています。この連鎖をリスクチェーンと呼んでいます。先述のようにテクノロジーだけではリスクは抑えられませんので、開発者だけでなくサービス提供者や利用者なども含め、全体で合意形成しながらリスク間を線でつないでいく必要があります。不確実性が高い技術に対して、みなさんの合意を得ながら、どのように運営していくか。そのためのフレームワークがリスクチェーンモデルです。

なお、AIサービスのリスクには、先に挙げた公平性や説明可能性のほかに、ビジネス目的を阻害してしまうというリスクもあります。例えば工場で使用する不良品検知のAIは、寒冷地や熱帯地方など、条件が異なると正しい判断ができなくなる場合があります。こうなると、AIサービスの目的を達成することができません。このようなリスクには、再学習を検討する、といったことも検討する必要があります。

-- リスクの関連性をフレームワークで見ていくのですね

例えば公平性のリスクで考えます。まずは、学習データに大きな偏りがあるリスクを検討します。実際のAIモデルを生成したときは、どういう項目に注目して判断しているのか、使用している変数(採用AIであれば、性別、学歴、国籍など)が妥当かどうかも検討が必要です。また、学習データに含まれない内容は、うまく予測できないリスクが高くなります。このようなデータでは、人間が判断する運用にするなど、対応策を考えておきます。

このようなリスク要素を、関連付けて考えて行くためのフレームワークがリスクチェーンモデルです。

このフレームワーク自体はすでに実際のデロイト トーマツにおけるコンサルティングでも活用されています。

リスクチェーンモデルが目指したのは、「どういうサービスなら受け入れられるか」をステークホルダーみんなで考えるためのツール

--これまでに印象に残ったプロジェクトにはどんなものがありますか?

ある自治体のスマートシティでの活動として、街中のAI(防犯)カメラの運用について、市民のみなさんに活用のアイディアを考えてもらい、そのリスクをリスクチェーンモデルで検討してもらうワークショップを開いたことですね。

例えば、街には犬が好きな人も、好きでない人もいます。AIカメラ活用のアイディアとして、「画像を使って、犬の散歩によく使われるコースを導き出してはどうか。犬好き同士が集まれるし、犬が苦手な人はあまり接触しなくてすむルートが知りたいのではないか」というアイディアが出たりします。これについて、リスクチェーンモデルを使って検討していただいた結果、参加者のみなさんから「犬が好きな人と嫌いな人で不要な分断を生んでしまうのでは」「犬の散歩ルートが密集すると小型犬が大型犬にいじめられることもあるかもしれない」などの潜在的リスクが指摘されました。

※参照:柏の葉アーバンデザインセンター(UDCK)みんなの街づくりスタジオ「AIカメラ編」より。詳細はこちら(外部サイト)

もともとリスクチェーンモデルが目指したのは、「どういうサービスなら受け入れられるか」をステークホルダーみんなで考えるためのツールですので、利用者である市民のみなさまを巻き込んだワークショップができたことはとても印象に残っています。

--AIカメラには可能性もリスクも潜んでいます

AIカメラだとプライバシーが懸念されるケースが多いですが、市民のニーズには防犯もあります。特に子どもの通学路はきちんと録画して監視をしてほしいと。そうしたニーズとリスクは一体で考えるべきですので、場所や時間帯でどう監視を強化するか(録画するか)はうまく最適化していく必要があります。

--ビジネス目的でAIを活用するときにも加減が難しそうですね

少し古い話ですが、アメリカのある小売チェーンで問題になった事例があります。そのチェーンでは、購買履歴からニーズを割り出し、クーポンを発行して売上増に結びつけていました。あるとき、若い女性にベビー用品のクーポンが発行されたのですが、彼女はまだ家族に妊娠を告げておらず、そのクーポンをきっかけに家族に妊娠が伝わってしまったらしいのです。

難しいのは、AI活用の結果がプライバシー保護から見て許容できる範囲なのかどうか、というところです。最近では「責任あるAI(レスポンシブルAI)」という言葉も使われますが、AIが出す結果に対してサービス提供者がどう責任を果たしていくかは今後重要な課題となるでしょう。

AIガバナンスとは、必要なときにブレーキをかけるためのもの

--実際にいろんなプロジェクトを経験してあらためて思うことはありますか?

ここ1年、本当にAIガバナンスに関する相談が増え、リスク管理や対策が重要なテーマになっています。その中で感じたのは、これまで以上に日本企業の縦割り文化を壊していく存在が求められているなということです。

もちろん、縦割りがすべて悪いわけではありませんが、近年のDXやAIでは、幅広い領域からデータを収集し、どこでAIを実行して、その結果をどこに開示するのかが問題になるため、横の連携が必要になってきます。

さらに、AIがビジネスと密接に関わりメリットを生み出す一方で、同時にコンプライアンスについて考えていく必要があります。AIガバナンスとは、必要なときにブレーキをかけるためのものです。AI自体を開発しているデータサイエンティストにアクセルを踏みながらブレーキをかけてくださいとお願いするのは困難です。

では誰がブレーキ役にふさわしいかを考えると、そのAIを開発部門以外で、ビジネスのニーズを正しく理解し、サービスがもたらすリスクや社会的な課題などを幅広い視点から考えることができる方々です。そうした方が企業内で孤立してしまうことがないように、うまく活躍できるように支援することが、デロイトに期待されているのではないかと感じています。

AIに限らず、何が課題であるかを発見し、主体的に動けることが大事

-- デロイト トーマツならではの先進性や優位性はどんなところにありますか?

私はDeloitte AI Instituteの枠組みで活動していますが、デロイト トーマツにはAI以外にもさまざまなエマージングテックの専門家がいます。最近ならブロックチェーン、Web3、メタバース、量子コンピュータなどですね。

サービスというのは、何か1つの技術だけでなく、さまざまな技術を組み合わせて構築されます。デロイト トーマツにはそれぞれの専門家がいて、相互に知恵を出し合いながらアーキテクチャやガバナンスを考える体制があります。これはデロイト トーマツならではの優位性になるでしょう。

--デロイト トーマツではどのような人材が求められているでしょうか

大前提となるのは、顧客の課題を解決できることです。社内にはいろんな専門家がいますが、活躍できている人は専門領域にかかわらず顧客や社会の課題に対して専門知識をうまく活用できている人です。自分の専門性を顧客や社会の課題解決に活かしたいと気持ちがあれば、デロイト トーマツで活躍できると思います。

--「顧客のために」行動できるところが重要ですねかね

AIに限らず、何が課題であるかを発見し、主体的に動けることが大事です。実際にクライアントから期待されるのは、クライアントからの要求をただ受け入れるのではなく、クライアントが向かうべき道を正しく指し示すことだと思います。必要なときにはクライアントの隣に立ち、ステークホルダーを巻き込んでいく行動力が大事です。

--仕事から離れたところではどんなことで気分転換していますか?

リモートワークになってから料理に夢中になっています。スパイスカレーを作ったり、最近ではバスクチーズケーキを焼いてみました。料理中は普段使わない感覚、鍋が煮えている音や匂いを感じるので五感がリフレッシュされます。

普段の仕事や研究から開放されて頭を休めたいという思いもあるのですが、カレーを作っていたら論文の骨子が浮かんできたこともありました。ですから、キッチンにはメモ帳を置くようにしています。そういえば、リスクチェーンモデルが浮かんだのは品川駅のカフェでパスタを食べていたときでした。

--最後に、読者にメッセージをお願いします。

Deloitte AI Instituteは、AIをはじめとするさまざまな先端技術をどういうふうに社会実装するか、そのためにさまざまな活動をしています。先端技術を社会実装に結びつけていきたいと考えている方がいらっしゃいましたら、ぜひ一緒に仕事をしていきましょう。