Points de vue

Bâtir la confiance envers l’IA - Comment surmonter les risques et opérationnaliser la gouvernance de l’IA

Ce rapport aide les organisations à orienter leur démarche d’adoption de l’IA en décrivant les stratégies visant à opérationnaliser la gouvernance de l’IA tout au long de son cycle de vie. Pour être efficaces, les organisations doivent atteindre un équilibre entre l’utilisation accélérée de l’IA et la mise en place d’une gouvernance judicieuse pour en assurer la fiabilité.

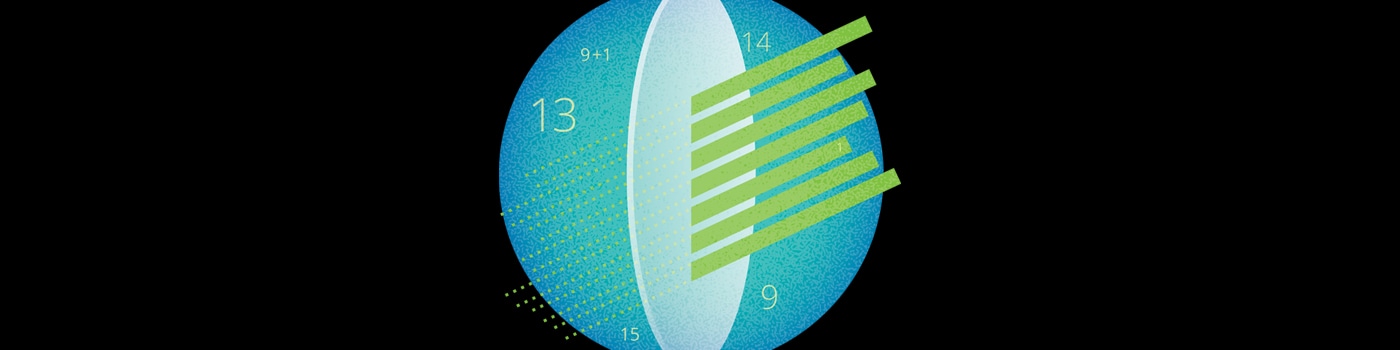

Cinq stratégies essentielles s’offrent à elles :

Déterminer les risques

Les organisations doivent déterminer les risques liés aux systèmes d’IA tôt au cours du cycle de vie. Cela permettra aux responsables et aux développeurs de système d’IA de prendre les bonnes décisions concernant la conception, le développement et le déploiement en vue d’instaurer la confiance, en plus de limiter les efforts consacrés à la reprise du développement. Parmi les pièges courants que peuvent entraîner l’évaluation et l’atténuation des risques au terme de l’étape du développement ou de la validation (assurance qualité), citons la nécessité de reprendre le travail, sans compter la perte de temps et d’investissements financiers si le projet ne peut être modifié et que, par conséquent, il ne peut être mis en oeuvre.

Adapter la gouvernance au système d’IA

La gestion des risques liés à l’IA mobilise un écosystème complexe d’intervenants, qui fournissent des directives et des stratégies d’atténuation en fonction de leur expertise fonctionnelle. Des experts dans les domaines de la confidentialité, de la conformité et de la sécurité, des scientifiques des données chevronnés, des éthiciens et des groupes interfonctionnels de leaders d’affaires jouent tous un rôle dans la gestion des risques liés à l’IA. Le responsable d’un système d’IA devrait être au courant des groupes de parties prenantes qu’il doit consulter pour assurer sa réussite et, par extension, les groupes auxquels il n’est pas nécessaire de faire appel étant donné les attributs du système d’IA. Cela exige une approche plus nuancée que dans le cas des niveaux de risque standard, qui peut être facilitée par une compréhension des principaux paramètres et attributs du système d’IA.

Mettre en oeuvre des autoévaluations

Les organisations dépendent grandement des responsables et des développeurs de systèmes d’IA pour déterminer les risques et adapter la gouvernance. Pour qu’il soit possible d’extraire la bonne quantité de renseignements, Deloitte a créé une autoévaluation de l’IA de confiance. Entre autres fonctions, cet outil recueille les paramètres clés du système d’IA pour évaluer les risques liés à l’IA qui nécessitent une attention et une analyse plus poussées, pour ensuite :

- Fournir des directives concrètes aux responsables et aux développeurs des systèmes d’IA afin d’éclairer leurs décisions de conception et de développement;

- Aiguiller les responsables des systèmes d’IA vers les experts (groupes ou fonctions) qu’ils doivent mobiliser

pour gérer ces risques;

Cet outil soutient également l’inventaire des systèmes d’IA et la production de rapports regroupés afin de permettre à l’organisation de mieux comprendre en quoi consistent l’adoption de l’IA, le RCI et le profil de risque global, entre autres renseignements pertinents.

Adopter des guides techniques

Les guides techniques fournissent aux développeurs de systèmes d’IA des directives tactiques propres à la situation. Ils visent les systèmes d’IA les plus courants au sein de l’organisation. Les guides stratégiques démontrent comment certaines techniques sont appliquées, et font référence à des outils et ressources libres ou acquis. Ils présentent aussi des techniques qui ont été testées et qui devraient avoir une longue vie utile, même s’ils doivent être révisés périodiquement à des fins de mises à jour des techniques, exemples et références.

Les guides stratégiques se prêtent particulièrement bien aux risques en matière d’équité et de caractère explicable, car leur atténuation s’applique au niveau du système d’IA individuel et nécessite souvent des méthodes techniques.

Tirer parti d’outils d’IA de confiance

Une fois que les responsables et les développeurs des systèmes d’IA ont utilisé l’autoévaluation pour dégager les risques liés à l’IA et prendre des décisions de conception éclairées, et qu’ils ont consulté les guides stratégiques techniques pour comprendre les mesures à prendre à un niveau détaillé, ils auront besoin d’outils logiciels pour améliorer leur système d’IA. Il peut s’agir de solutions libres ou acquises, conçues pour gérer les facteurs de risque tels que l’équité, le caractère explicable et la robustesse. Tandis que les organisations évaluent les coûts et les avantages de la création par rapport à l’acquisition de solutions, elles devront bien comprendre le contexte des logiciels, notamment les coûts réels, la personnalisation et le niveau de maîtrise nécessaire pour tirer efficacement parti des outils.