EU AI Act – EUの包括的AI規制の概説と企業の対応 ブックマークが追加されました

ナレッジ

EU AI Act – EUの包括的AI規制の概説と企業の対応

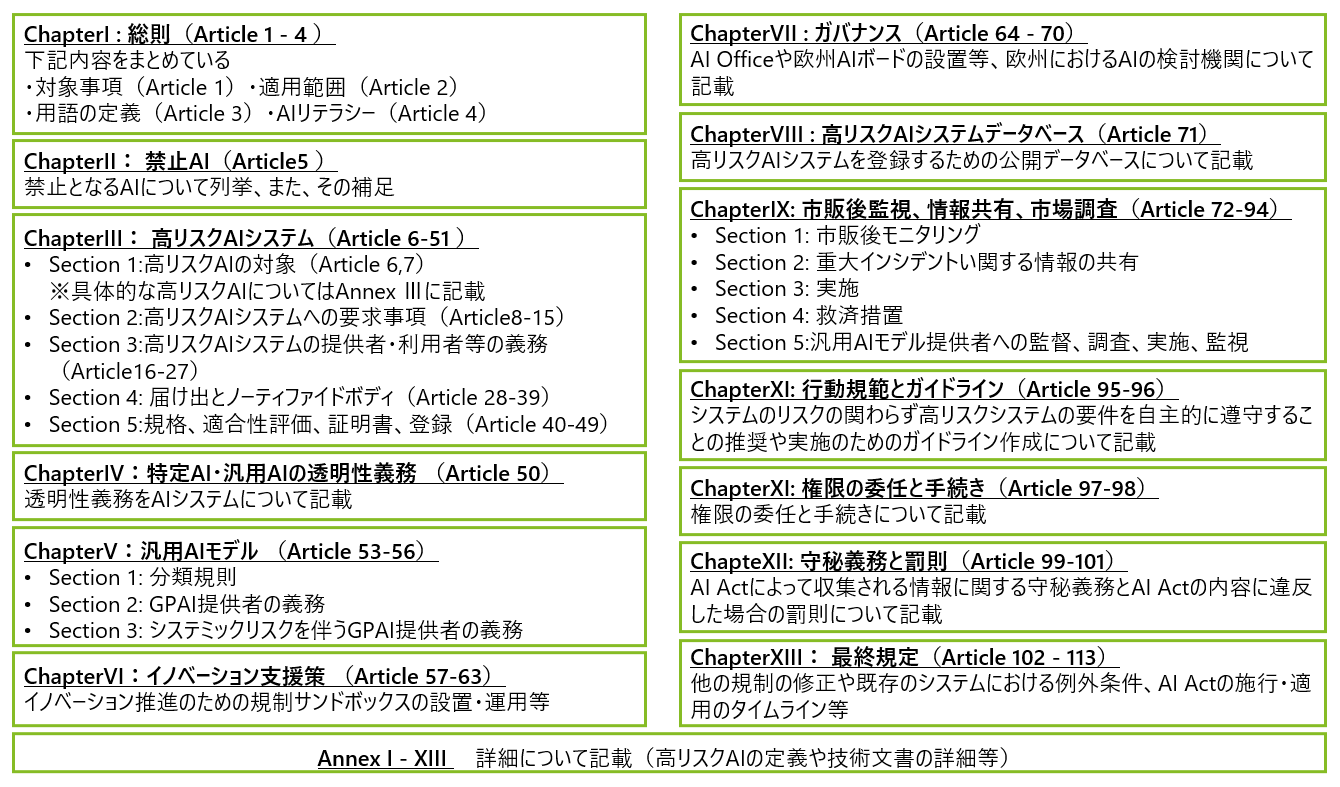

世界初の包括的なAIに関する規制であるEUのArtificial Intelligence Act (AI Act, AIA)は、2024年3月13日に欧州議会における採択を経て、最終的な全容が明らかになりました。2021年4月21日の欧州委員会における初めてのAI Act案の発表から、生成AIの勃興等に端を発して世界中でAIに対する規制における議論が広がり、様々なステークホルダーから様々な意見が上がる中で、AIの倫理・品質管理における企業が果たすべき社会的責任の1つの形が示されたことになります。

本記事では、EUの AI Actの概要を説明し、各社において今後の検討を進める中で考慮すべき事項をお伝えいたします。

※なお本記事は2024年4月16日に欧州議会から公開されたAI Actの最新版を踏まえて作成しております。

参考:https://www.europarl.europa.eu/doceo/document/TA-9-2024-0138-FNL-COR01_EN.pdf(外部リンク)

背景と概要

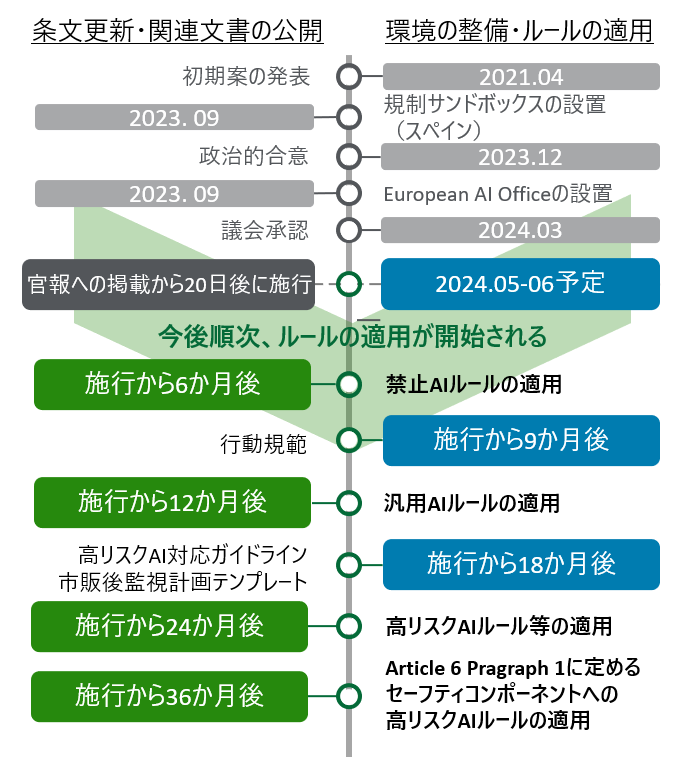

2021年4月に欧州委員会から発表され、議論が続けられていた、EUのAI Actが2024年3月13日に欧州議会にて採択されました。予定では、2024年5月にEUの官報にて公布され、公布から20日後に施行されることになります。その後、早ければ公布の6か月後から順次ルールの適用が開始されます。AI Actは、EU内の企業のみならず、EUの市場に対してサービスやシステムを展開する企業も対象となっており、日本の企業においても、内容を理解し対応の要否や態勢について検討する必要があります。

図:AI Actの構成

規制の対象者

AI Actは、EUの一般データ保護規制(GDPR)等のデジタル関連の規制・指令と同様にEU域外の企業も対象としており、EUに支社や子会社等がある企業に加え、サービスやシステムをEU市場に販売している企業も対象となるため、多く日本の企業も対応が必要になります。

具体的には下記のように対象が整理されております。(Article 2)

(a) EU内でAIシステム・サービス、または汎用AIモデルを市場に投入する提供者

(提供者がEU内または第三国に所在しているかに関わらず)

(b) EU域内に所在するAIシステムの導入者

(c) AIシステムによって生成された出力がEUで使用される、第三国のAIシステムの提供者および導入者

(d) AIシステムの輸入業者および販売業者

(e) AIシステムを自社製品とともに自社の名前または商標で市場に投入またはサービスを開始する製造業者

(f) 提供者(EUに設立されていない場合)のEU域内の権限のある代理人

(g) EU域内に所在する影響を受ける人

なお、記載されている各ロールの定義は下記の通りです。(Article 3)

※製造業者(product manufacturer)に関する定義は2024年4月時点では記載

提供者(provider) |

AIシステムもしくは汎用AIモデルを開発する、またはAIシステムもしくは汎用AIモデルを開発させ、有償・無償を問わず、自己の名称もしくは商標を用いて市場に流通させる、もしくはサービスを展開する自然人もしくは法人、公的機関、代理店、その他の団体 |

|---|---|

導入者(deployer) |

AIシステムを権限に基づいて使用する(個人的な非専門的活動の過程で使用される場合は除く)自然人または法人、公的機関、代理店、その他の団体 |

輸入業者(importer) |

EU域外の自然人または法人の名称または商標が付されたAIシステムを市場に出す、EU域内の自然人または法人 |

販売業者(distributor) |

提供者または輸入業者以外のサプライチェーン上の自然人または法人で、AIシステムをEU市場で入手できるようにする者 |

権限のある代理人(authorized representative) |

AIシステム、または汎用AIモデルの提供者から、書面でAI Actが定める義務及び手続を代理して実施することを委任され受諾した、EU域内の自然人、または法人 |

リスクベースアプローチ

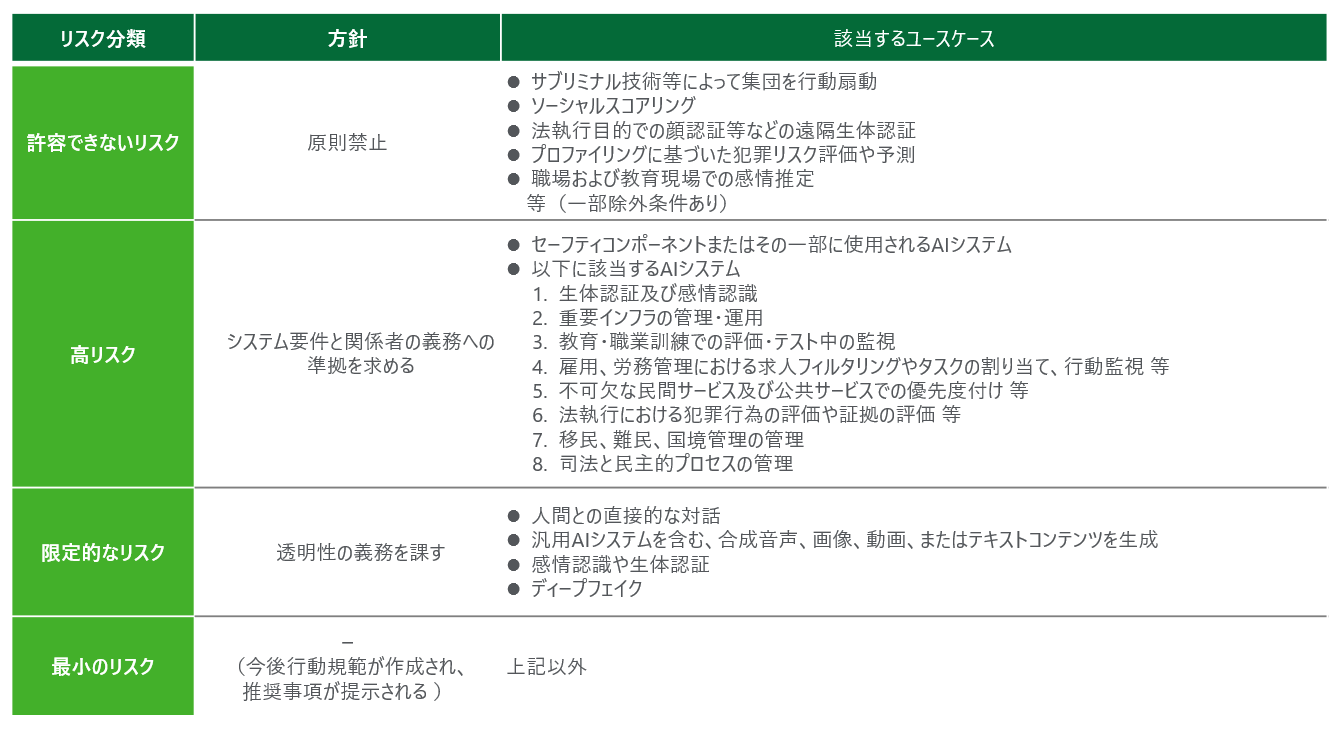

AI Actにおいては、様々ユースケースが保持する潜在的なリスクを「許容されないリスク」、「高リスク」、「限定的なリスク」、「極小リスク」の4つのリスクレベルに分類し、対応するリスクレベルごとに要件や義務を規定するリスクベースでのアプローチを定めています。

ゆえに、各事業者がAI Actへの対応を検討する上で、まず社内のAIがAI Actにおけるどのリスクに分類されるかどうかを把握することが重要です。

なお、AI開発においては、あるユースケースを目的として開発されたAIモデルを別のユースケースへ転用することはよくありますが、その場合、AI Actにおけるリスク分類が変動し、対応すべき事項が変わる可能性があるため、注意が必要です。

図:リスク分類の概要

許容できないリスク(Article 5)

対象者の人権をひどく侵害する可能性や対象者を悪意のある行動に導く可能性などが考えられえるAIシステムは、許容できないリスクに分類され、「禁止AI利用」 (prohibited AI practice)として、EU域内での利用が原則禁止されます。

高リスク (Chapter III)

教育や雇用公平性を毀損する可能性などが考えられるAIシステムは、「高リスク」に分類され、利用に際しては、システムの要件や義務の遵守が規定されています。

また、機械や医療機器等の既存法規において、適合性評価の対象となるセーフティーコンポーネントについても、同様の規定が適用されます。

一方で、自動車や航空等の一部の領域におけるセーフティーコンポーネントについては、それらの関連する法規をAI Actの高リスクに対する規定を考慮しながら改正することとされており具体的なルールは今後決まることになります。(Article 2 Paragraph 2)

限定的なリスク(Chapter IV)

出力した内容が、人間によって直接参照されることによって、間違った認識を生む可能性のあるAIについては、AIが生成した出力であることを利用者に明示する「透明性の義務」が課されている。

最小のリスク

上記3つ以外のAIシステムについては、基本的には要件や義務は定められていません。一方で今後作成される予定の行動規範(Code of Practice)に応じた対応を実施することが推奨されています。(Article95)

加えて、昨今注目を集めている、生成AIをはじめとした汎用AIモデル(General Purpose AI, GPAI)※1については、各モデルが特定のユースケースに紐づかず様々なタスクに適用可能であるため、上記リスクレベルとは区別して要件や義務が定められています。(Chapter V)

※1 汎用AIモデルとは大規模な自己監視を用いて大量のデータで訓練された場合を含め、著しい一般性を示し、モデルが市場に投入される方法にかかわらず、幅広い異なるタスクを適切に実行することができ、かつ、様々な下流のシステム又はアプリケーションに統合することができるAIモデルを意味する(Article 3 44b)

要件や義務

<高リスクAIシステム>

高リスクAIシステムにおいては、リスクを抑制・管理していくために、高リスクAIシステムに対する要件が定められています。

高リスクAIシステムに対する要件

- リスク管理システム(Article 9)

- データガバナンス(Article 10)

- 技術文書(Article 11)

- 記録保持(Article 12)

- 透明性と導入者への情報提供(Article 13)

- 人による監視(Article 14)

- 正確性、堅牢性、サイバーセキュリティ(Article 15)

また、サプライチェーン上の各事業者に対しては、デプロイ後までを含めたAIのライフサイクルを通して継続的に高リスクAIシステムに対する要件への遵守を維持するために義務事項が課されています。

その中でも、最も重い義務が課されているのが提供者です。提供者に対しては、システムの要件をすべて満たすことに加え、適合性評価の実施やEUの設置するデータベースへの登録等が課されています。(Article 16)

なお、自社でAIシステムを開発する場合のみならず、他社にAIシステムの開発を委託する場合も自社のサービスとして市場に展開する場合は、提供者に当たるため注意が必要です。

次に、高リスクAIの輸入業者や販売業者は、提供者が行った適合性評価や作成された技術文書の確認を行う必要があります。(Article 23-24)

最後に、導入者においては、基本的権利影響への評価を実施しなければならない旨が記載されています。(Article 27)

<汎用AIモデル>

汎用AIモデルの提供者(OpenAI社 等)に対しては、主に、下記のような義務が定められています。(Article 53)

a. モデルの学習・テストの過程と評価結果を含む技術文書の作成

b. モデルを使用するAIシステムプロバイダへの情報とドキュメントの提供

c. 著作権法遵守に関する方針策定

d. 学習に使用するデータに関する詳細情報の作成

また、汎用AIモデルの中でも、特に影響が大きいと考えられるものは、システミックリスクを伴う汎用AIモデルに分類され、その提供者は、敵対性テストやリスクの評価、サイバーセキュリティの強化など追加の義務が課されます。(Article 51, 55)

なお、汎用AIモデルの開発は行わず、他社が開発した汎用AIモデルを利用したシステム・サービスの提供者においては、「透明性の義務」が課されております。また、ユースケースによっては高リスクAIに対する規定に準拠する必要も出てくると考えられます。

以上のように、特に高リスクAIシステムや汎用AIモデルの利用局面においては、多くの複雑な要件や義務が規定されています。

一方で、AI Actは主に「WHAT(何を達成すべきか)」に重点を置いた文書であり、「HOW(どのように達成すべきか)」が明確ではないため、これだけでは、各事業者が対応に苦慮することが見込まれます。

そのため、実際に法規対応の検討や対応の妥当性を判断していくためには、AI Actの条文の理解のみならず、今後AI Officeと欧州委員会が作成する高リスクAIの要件や義務への対応ガイドライン(Article 6, 96)や整合規格(Article 40)を参考とする必要があります。

罰則

AI Actでは、特に高リスクAIシステムに対する要件や事業者の義務が複雑である一方で、罰則も厳しく設けられており、各社においては、無視することができない法令となっております。(Article 99)

- 禁止AIルール違反

- 最大で35,000,000ユーロ、または、前会計年度の全世界の年間総売上高の7%のいずれか高い方

- 高リスクAI、もしくは、透明性を伴うAIルール違反

- 最大で15,000,000ユーロ、または、前会計年度の全世界の年間総売上高の3%以下

- ノティファイドボディや各国の所轄当局への不正確、不完全、又は、誤解を招く情報の提供

- 最大で7,500,000ユーロ、または違反者が企業である場合は、前会計年度の全世界の年間総売上高の1%のいずれか高い方

スケジュール

AI Actにおいて、各社における本格的な対応が求められる高リスクAIに対するルールの適用は、施行日から2年後と定められているため、2026年の5-6月になる予定です。一方で、禁止AIや汎用AIに対するルール等、それよりも前に適用が開始されるルールもあるため注意が必要です。(Article 113)

図:AI Act関連タイムライン

デロイト トーマツが考える、EU AI Act対応をきっかけとしたAIガバナンスの実装

AI Act対応を進めていく上では、上記の様に適切なリスク判断とそれに応じた対策をサプライチェーン全体で実施していく必要があるため、全社、さらには、関係企業を踏まえた検討体制を構築する必要性も生じてくると考えられます。

実際にリスク管理システムを構築していく際にも、業務・倫理・技術的なリスクの洗い出しやリスクへの対応の検討、また、それらの事項の確認・承認など様々なステークホルダーがそれぞれの専門性を持ち寄って対応していくことが想定されます。

今後全社、関連企業を巻き込んだAI Act対応を進めていくためには、今から社内の態勢や方針の検討や社内のAIの利活用状況の把握・整理を進め、今後具体的な基準が整備され次第、それを社内の具体的なプロセスやルールに落とし込めるような土台を作っていくことが肝要です。

デロイト トーマツではこの難しい課題に対し、「実践」、「連携」、「反映」の三点を重視し、AIガバナンスの高度化に取り組んでいます。

詳しくはAIガバナンス – 生成AI時代に求められる信頼できるAIの実現の道筋をご覧ください。

その他の記事

AIガバナンス – 生成AI時代に求められる信頼できるAIの実現の道筋

デロイト トーマツが提唱する、生成AIをはじめとしたAI利活用のための基盤づくり

アナリティクス サービスメニュー: インダストリー別

アナリティクス関連サービスの提供についてインダストリー別に紹介