対話型生成AIを活用するためのプロンプトガバナンス ブックマークが追加されました

最新動向/市場予測

対話型生成AIを活用するためのプロンプトガバナンス

プロンプトガバナンスは対話型生成AIの利用において人間とAIの対話プロセスにアラインしたアプローチです。

現在広く利用されている汎用目的の対話型生成AIはユーザーとの対話のみならず、プラットフォーム側のアップデートによっても振る舞いを変えることがある。このような日々変化する対話型生成AIの特徴を踏まえると、従来の特定目的に向けて開発されたAIとは異なるガバナンスが必要になる。そこで、対話型生成AIの利用において人間とAIの対話プロセスにアラインしたプロンプトガバナンスというアプローチを提案する。

対話型生成AIで可能になることは?

ChatGPTをはじめとする対話型生成AIは、人間を相手に日本語を含む多言語で自然な会話が可能なAIチャットサービスであり、高い「汎用性」を備えている。「対話」を通して様々な使い方が考えられるが、大きく三つの用途がある。一つは「調査・分析」用途であり、既にある情報を効率的かつ人間が把握しやすい形にまとめるといったことが可能である。二つ目が「創作」用途であり、事実・フィクションに関わらず、新しいストーリーをつくり出すことができる。最後に「対話」用途。コールセンターの応答やコーチングのような様々な人間との対話を用いることができ、相互の発言によってAIも振る舞いを変えながら、人間も新たな気づきを得ることが可能である。

対話型生成AIに関わるリスクとは何か?

対話型生成AIは、既に米国の医師資格試験などの数多くの「人間のタスク」で人間に匹敵する「性能」を発揮しており、労働や教育現場において人間の役割が代替され、変化していくことが指摘されている。またビジネス・生活の様々なシーンにおける活用に期待が高まる一方で、さまざまなリスクが懸念されている。従来のAI利活用においても問題提起されていた公平性、透明性、安全性、セキュリティなどのリスク以外に、対話型生成AIはその汎用性故に発生する固有のリスクがある。何の目的で、誰が利用しているか分からないサービスになっているため、リスクの多様化、影響範囲の拡大、リスク顕在化頻度の増加などリスク対策の難易度も上がっている。

特に現在広く活用されている対話型生成AIはユーザーとの対話に限らず、プラットフォーム側のアップデートによって振る舞いを変えることがある。例えば、Open AIのChatGPTはユーザーとの対話時に「Like/Unlike」のフィードバックを得ており、また倫理的な配慮も踏まえて、日々アップデートをかけている。筆者の体感でも、2023年1月頃は「特定の有名人のように振る舞った発言」をさせることができていたが、最近ではそういった振る舞いをChatGPT側が「できない」と回答するように変化している。またサードバーティが提供するWebサービスと連携するプラグインも活用が広がっている。

このような日々変化するプラットフォームサービスがビジネス・生活の様々なシーンに定着した際に、AIと対話する人間は変化に適切に対応することが必要となり、適切に利活用を行っていく上では次の3点が重要となる。再現性(Reproducibility)がなくなること、同期性(Synchronicity)が維持されないこと、また、これにより追跡可能性(Traceability)の確保が必要になることである。

再現性(Reproducibility)がなくなることとは、対話型生成AIに同じ質問をしても、これまでと全く異なる発言が返ってきたり、回答できなくなることである。例えば、商品開発のマーケティングにおいて「特定のインフルエンサーとしてふるまって、ある商品についてレビューしてください」という使い方ができていたとしても、倫理的な配慮から個人としての発言を控えるような振る舞いに変化があり、有効な回答が得られなくなる可能性がある。

同期性(Synchronicity)については、まずLLMの学習データ(ファインチューニング時の独自データも含む)がいつ時点のものかという点が重要である。ChatGPTの場合、最近ではウェブの最新情報にアクセスできる手段が存在するようになったが、以前は2021年9月時点の情報に基づいた回答しか返すことができなかった。またプラグインを介して外部Webサービスとの連動した使い方を行う場合、外部サービスが持つ情報の更新頻度に影響を受ける可能性がある。

追跡可能性(Traceability)の確保は、AIと利用者の対話において問題が生じた際に原因の特定が難しいことと言う点で重要である。例えば「AIの発言が公平ではない」という疑念が生じた場合、その原因となるバイアスは、LLMもしくはファインチューニングの学習データなのか、モデルの学習方法なのか、利用者の入力したプロンプトに問題があるのか、外部サービスに情報の偏りがあったのか、と多岐の構成要素で懸念される。しかし、利用者が獲得できるのはあくまでもAIの回答1つであり、原因の特定が難しい。開発の過程から過去の対話・外部サービスとの連携を含めて、追跡可能性を確保することが必要である。

プロンプトガバナンスとはどのようなものか?

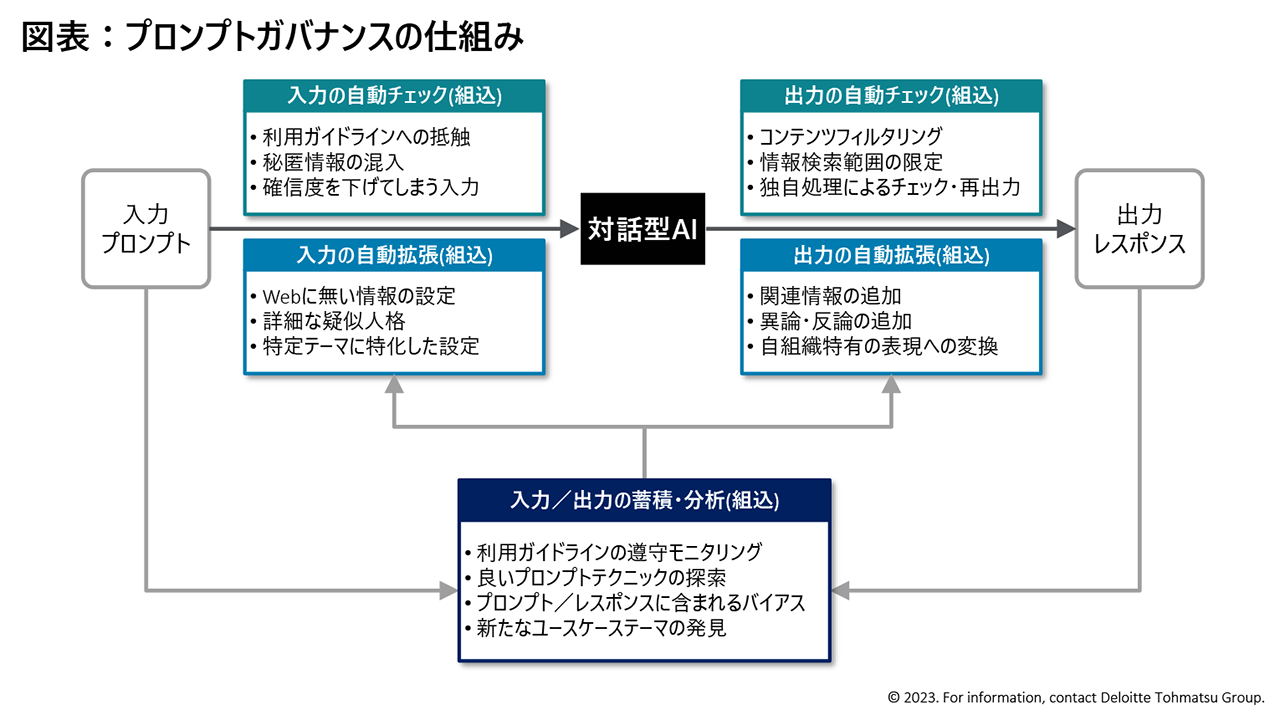

以上の論点を踏まえると、汎用目的(General Purpose)で用いられる対話型生成AIは、従来の特定目的に向けた開発されたAIとは異なるガバナンスが求められる。そこで、対話型生成AIの利用において人間とAIの対話プロセスにアラインしたプロンプトガバナンスというアプローチを提案する。プロンプトガバナンスは、人間の入力(プロンプト)とAIの出力(レスポンス)の過程に「自動チェック」や「自動拡張」の機構を組み込み、人間とAIの対話を「蓄積・分析」することでガバナンス機能を改善・拡張していく仕組みである。

具体的には、入力の際のガイドラインの抵触、秘匿情報の混入などを阻止する自動チェック機能や、入力の補助や制御のための自動拡張を組み込む。また、出力の際にはコンテンツのフィルタリング、検索範囲の限定、独自処理におけるチェック・再出力といった自動チェックに加えて、関連情報や異論反論の追加、自組織特有の表現への変換といった拡張機能を組み込むことができる。

加えて、蓄積されたプロンプト及びレスポンスを分析することによって、利用ガイドラインの遵守状況や利用者が行った良いプロンプトテクニックの探索、組織内におけるバイアスやコンプライアンス状況の把握、新たなユースケーステーマの発見といった気付きを得ることができる。

このようにプロンプトガバナンスを実践することによって、人間とAIのインタラクションにおいて適切なガバナンスを機能させ、全社員が“正しく”多目的へ“有効に”利用できる汎用目的AIの構築に貢献することが期待できる。様々な企業で実践が進められ、通常のビジネスにおいて自然に発生する対話がデータとして獲得され、戦略・ガバナンスの両面で活用し、企業の成長に貢献することが期待される。

その他の記事

生成AI(Generative AI)から企業価値を生みだす方法

デロイト グローバルで発表された記事『The implications of Generative AI for businesses』の翻訳版です。

AIガバナンス策定・実行支援

企業の特性に適したAIガバナンスの体制構築を実現