NIST AI Risk Management Framework(AIリスクマネジメントフレームワーク) – 概説 ブックマークが追加されました

ナレッジ

NIST AI Risk Management Framework(AIリスクマネジメントフレームワーク) – 概説

目次

- 米国におけるAI安全性対策の全体像

- AI RMFとは

- AI RMFが提案するAIリスク管理のコア

- AI RMF実践のロードマップ

- デロイト トーマツが考える、AI RMFベースとしたAIガバナンス態勢構築

現在、生成AIの勃興を契機に世界中でAIのリスク管理に関する議論が活発になされております。実際に2023年11月には、イギリスでAI Safety Summitが開催され、20を超える国をはじめAIの利活用やリスク管理に係る研究機関・企業が参加し、国際社会の利益に資する安全かつ責任あるAIの利活用に関する世界的な合意がなされました。また、日本政府はG7・広島AIプロセスの活動を牽引しながら、具体的な取り組みに関する国際的な議論の活性化を促しています。

各企業に向けた法規やガイドラインとしては、EUにて検討が続けられてきた世界初のAIの包括的規制法であるArtificial Intelligence Actが2024年5月にEU理事会にて承認されたことを受け施行間近となっており、今後各社対応を進めることが想定されます。(詳しくは、EU AI Act – EUの包括的AI規制の概説と企業の対応を参照)

一方で、日本国内においては、現状ハードローによる規制ではなくガイドライン等による事業者の自主的なAIガバナンス実施による対応推進を目指しております。(生成AIの開発者向けに関する法案は現在検討中※1。また、内閣府AI戦略会議にてその他のAIに関してもAI制度の在り方の検討が開始※2。)総務省や経済産業省では、これまで各政府機関等で作成されてきていたAIリスク対策に係る文書群を集約した「AI事業者ガイドライン」を発行するなど環境整備を進めています。(詳しくは、AI事業者ガイドライン – 解説を参照)

米国においては、州別にユースケースを絞った州法を制定するなど一部ハードローによる環境整備が行われているものの、基本的には日本と同様に企業との対話を通した自主的な対応を求めています。本記事では、日本と同様にガイドラインベースの施策を取っている米国においてベースとなっている、米国国立標準技術研究所(以降、NIST)の「AI Risk Management Framework 1.0」(以降、AI RMF)の概要をご紹介します。日本のAI Safety Instituteと米国のAI Safety Instituteの連携し、AI事業者ガイドラインとAI RMFのクロスウォークが公開されるなど、今後日本においても存在感が増すことが想定されるAI RMFの理解の第一歩になれば幸いです。

※1自由民主党 AIの進化と実装に関するプロジェクトチーム「AIホワイトペーパー2024_概要版」:https://www.taira-m.jp/AI%E3%83%9B%E3%83%AF%E3%82%A4%E3%83%88%E3%83%9A%E3%83%BC%E3%83%91%E3%83%BC2024_%E6%A6%82%E8%A6%81%E7%89%88.pdf

※2内閣府 AI戦略会議 第9回 資料2-1「「AI制度に関する考え方」について」:https://www8.cao.go.jp/cstp/ai/ai_senryaku/9kai/shiryo2-1.pdf

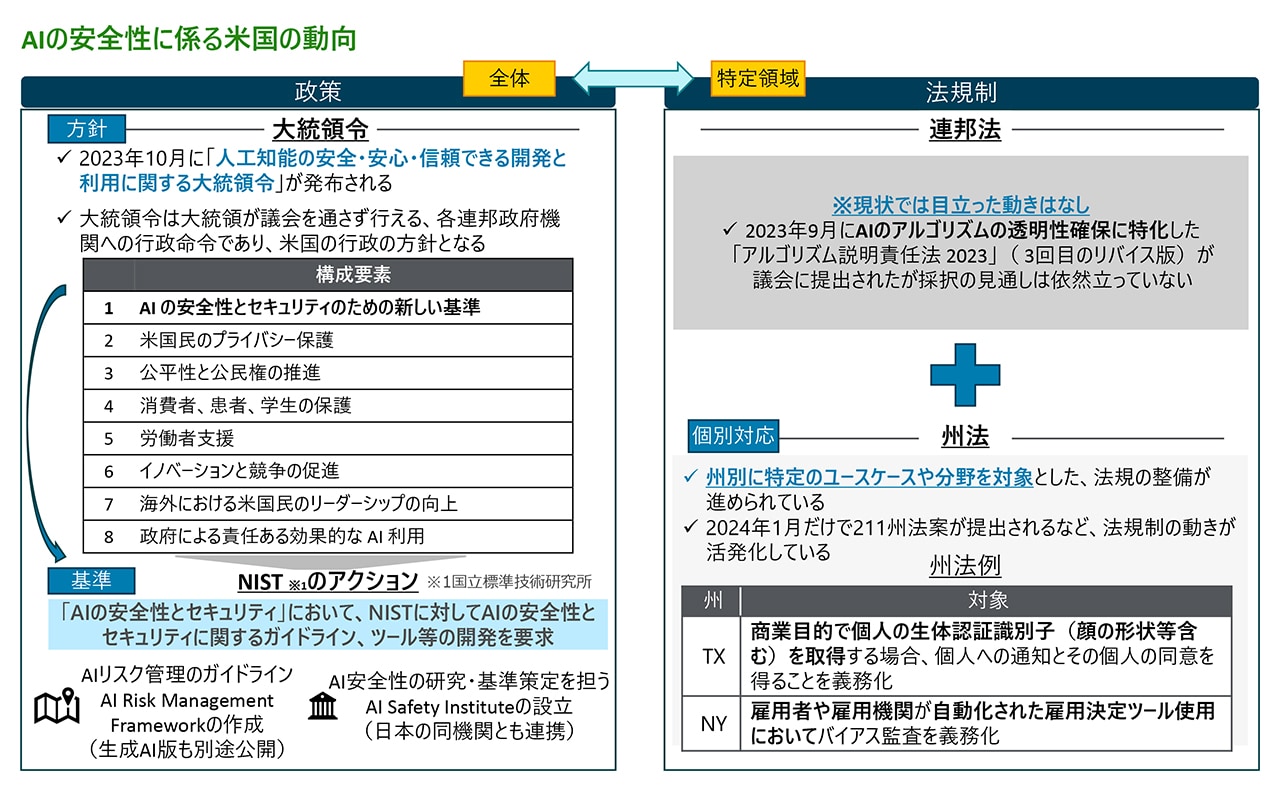

米国におけるAI安全性対策の全体像

米国における、AI安全性対策の全体像は図1のように表現することができます。上記でも言及したように特定領域における基準・ルール形成は、州法を中心に法規での整備が進められています。一方で、AIの安全性対策の全体的な方針や基準・ルール形成については、2023年10月に発布された大統領令(Executive Order on the Safe, Secure, and Trustworthy Development and Use of Artificial Intelligence)でも方針として示されているように、NISTを中心として継続的にガイドラインやツールの開発を推進していくことになると考えられます。実際に2024年4月にはNISTから生成AI にリスク管理に特化したガイドラインである「Generative AI RMF Profile」が公開されています。

図1:米国におけるAI安全性対策の全体像

AI RMFとは

AI RMFは、2023年1月にNISTから発行された、企業における自主的な信頼できるAIの開発・導入・利用を支援するために設計されたAIのリスク管理に関するフレームワークです。AI RMFは、2部編成となっており、Part 1は「Foundational Information」と題してAIリスクの特徴や関与者、信頼できるAIについて、Part 2は「Core and Profiles」と題してAIのリスク管理を推進していく上での実務上の確認観点がまとめられています。

また、AI RMFの付属書として公開されている「AI Risk Management Framework Playbook」では、本編で示されている個別の確認観点別の「詳細説明」・「推奨アクション」・「透明性/文書化」・「参考文献」が列挙されており、企業にとっては分量が多く詳細を理解するには労力を要するものの、AIリスク管理において実施すべき事項の総量を捉えるには、有益な情報になっております。

一方で、AI RMF内でも明記されているように、当該文書はいずれの業界や規模の企業、様々なユースケースにおいて活用できるよう設計されているため、自社のAI活用状況や利活用戦略を考慮しながら、必要な要素を取捨選択し、自社に適した形で”利用”していくことが重要です。

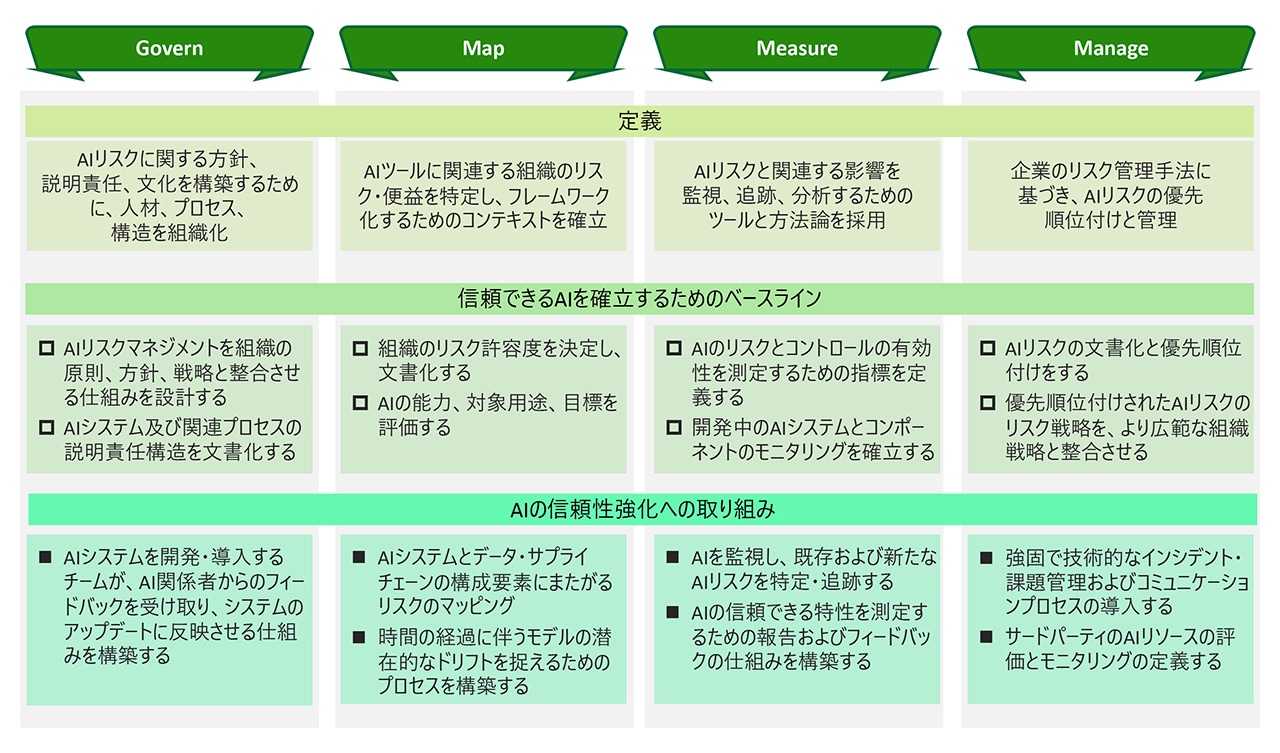

AI RMFが提案するAIリスク管理のコア

AI RMFにおいては、AIのリスク管理の要素を「Govern」、「Map」、「Measure」、「Manage」の4つのコアに整理しています。そのうえで、それぞれのコアごとにカテゴリとサブカテゴリに分割しながら、アセスメントの観点をまとめています。

図2:4つのコアと具体的な取り組みイメージ

具体的には、人材・プロセス・組織構造に関するAIリスク管理の全体を包括する観点(Govern)と、リスク・便益の特定(Map)、リスク評価・分析の方法論整備(Measure)、リスクの対応優先度付けと対応策検討(Manage)といった実際のガバナンス構築のステップに沿ったアセスメントを行うことが可能な形式になっています。

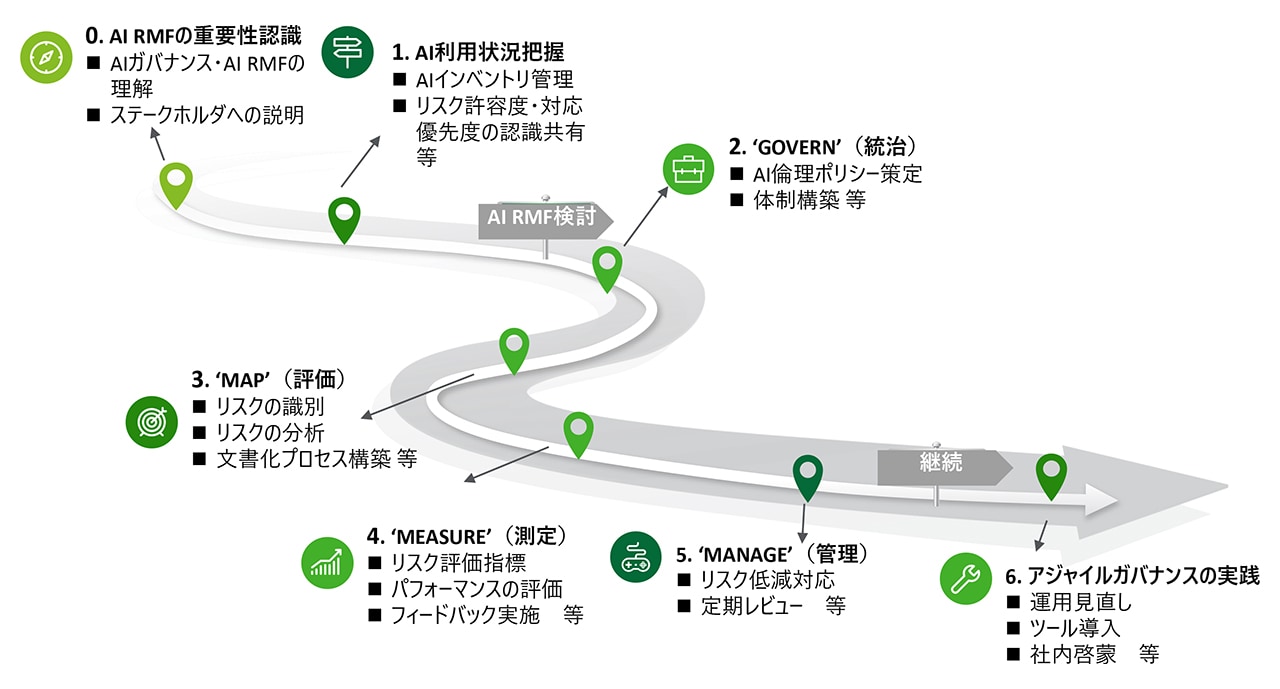

AI RMF実践のロードマップ

一方で、AI RMFで示されている事項を全て満たす必要は必ずしもなく、自社の状況と方針に合った態勢を目指すことが重要です。そのため、4つのコアに基づいた検討を始める前に、まずは、問題意識の共有や社内の状況把握から始めることが、以降の整理を効率的に進めるうえでの第一歩となります。また、実際の社内のAIの利活用状況を整理し、管理可能なインベントリ環境を整えることで、AIの利活用を支えるガバナンスの実現に大きくつながります。

図3:AI RMF実践のロードマップ

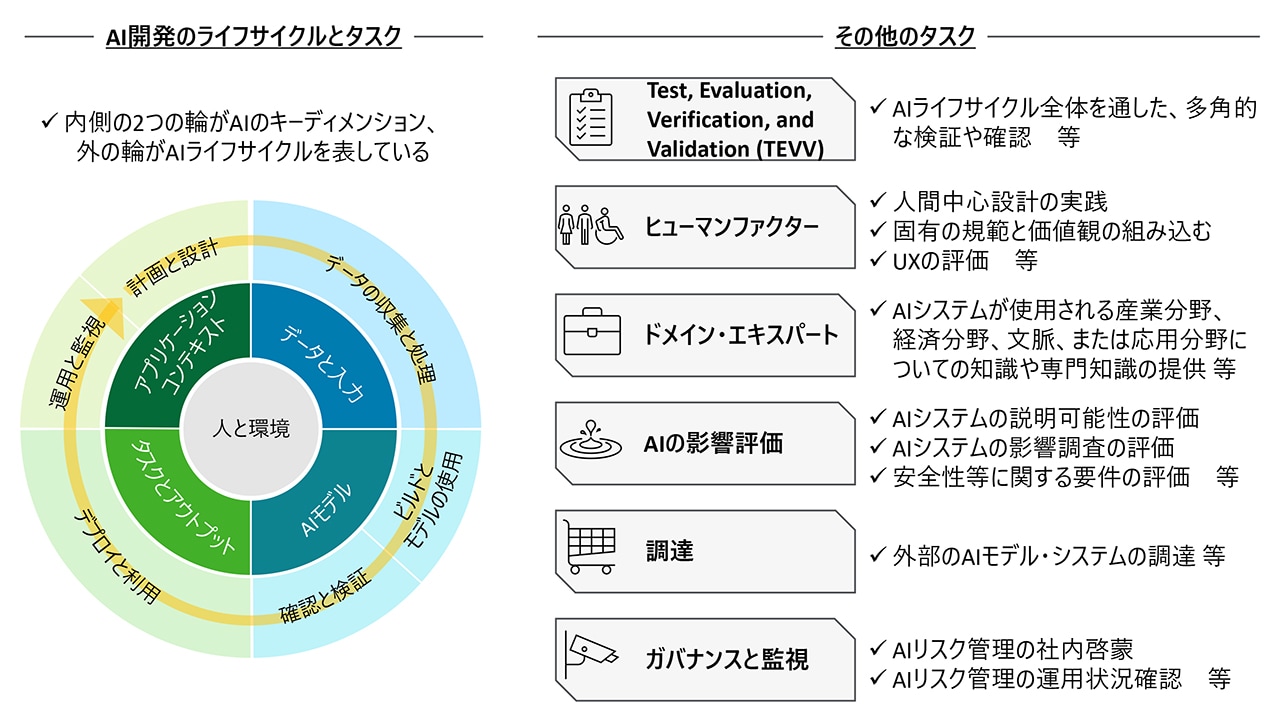

また、社内の人材の評価においては、AIライフサイクルにおけるタスクやアクターの整理を参考にすることができます。AI RMFには、タスクごとの細かなアクターが整理されているため、自社が担うタスクに沿って必要な人材・スキルセットを確認しながら、自社で補うか・外部を巻き込みながら体制を充実させるのかを検討することができます。

例えば、社内でAIのモデル・システムの開発を行っていない会社においても、外部に開発を委託する、もしくは、外部から調達するモデル・システムに対しても、適切にリスク管理を実施することで、会社の理念に沿ったAIの利活用を推進できます。

図4:AI RMFが提示するAIライフサイクルとその他のタスク

デロイト トーマツが考える、AI RMFベースとしたAIガバナンス態勢構築

以上のように、AI RMFは、社内のAIガバナンス態勢構築に向けた第一歩を踏み出す際に参考とする資料としては、充実した内容となっています。一方で、社内のAIの利活用状況を踏まえずにAI RMFの内容を参照すると、実際に必要な対応を抽出することができず、ガバナンス態勢の実現が頓挫してしまうことも考えられます。そのため、社内におけるAIの利活用状況や方針、他のガバナンスとの整合性を把握したうえで、想定される様々なステークホルダを巻き込みながら、全社一丸となって対応を進めることで、AIの利活用を支える基盤となるようなAIガバナンス態勢を構築することが重要になります。

デロイト トーマツではこの難しい課題に対し、「実践」、「連携」、「反映」の三点を重視し、AIガバナンスの高度化に取り組んでいます。

詳しくはAIガバナンス – 生成AI時代に求められる信頼できるAIの実現の道筋をご覧ください。

その他の記事

AIガバナンス – 生成AI時代に求められる信頼できるAIの実現の道筋

デロイト トーマツが提唱する、生成AIをはじめとしたAI利活用のための基盤づくり

アナリティクス サービスメニュー: インダストリー別

アナリティクス関連サービスの提供についてインダストリー別に紹介