AIガバナンスの新潮流 ブックマークが追加されました

ナレッジ

AIガバナンスの新潮流

欧州AI規制案等のAIへの規制の世界的な潮流にいかに日本企業も対応するべきか

欧州AI規制案は2024年末にも施行する見込みが提示されている。欧州以外にもAI倫理問題を受け、AI規制の潮流が形成される一方、プラットフォーマーをはじめとする一部企業がAIガバナンス体制を構築し、順応しつつある。AIガバナンス先進企業は、規制当局との連携を図り、政府機関が検討する法規制案への影響をも強めている。政府機関とAIガバナンス先進企業が織りなす潮流を踏まえ、今後のAIガバナンス構築の検討が重要となる。

AI倫理とは

AIガバナンスへの取り組みは、AIのリスクへの対応でもある。

AIのリスクは、小説や漫画、映画等でロボット等の形に化体し、ヒトを脅かす存在として描写されることもあった。また、2013年には英オックスフォード大学マイケル・A・オズボーン教授の論文「The Future of Employment」*1では、2050年までにAIにより47%の職が失われると論じられ、社会に大きな衝撃を与えたのは記憶に新しい。AIのシンギュラリティ*2についても、AIのヒトへの影響を懸念する声につながったともいえる。

AIシステムが引き起こした事件を見てみる。総務省によれば、ディープラーニングを背景として2000年代より現在は第三次AIブームと呼ばれている*3。このディープラーニングの登場後に、AIがヒトの尊厳を冒した事例として、画像のタグ付けでヒトをゴリラと認識したものが挙げられる*2。人種差別を背景とした同事例は、ヒトへの精神的な苦痛を与えるものといえる。なお、このヒトの尊厳は生死によらずに故人にも及ぶ。

2021年1月には、死者とも仮想上の会話ができるチャットボット技術に係る特許を大手ソフトウェア開発・販売企業が取得し、ネットで物議を醸した。ネットでの反応に対して、この企業のAIプログラム担当者は同月に、「(製品化の)計画はないことを確認する」とツイートし、あわせて出願した2017年4月時点では、現在のようにAI倫理を巡る厳しい目が向けられていなかった」と言及していた。

上記の事例は、故人の尊厳を冒すものとして批判を浴び、製品化計画を手控える発表に追い込まれたものであった。

経済的な苦痛をもたらす事例としては、人材AIや金融分野で用いられるスコアリング*4も主要な問題として挙げられる。例えば、男性が多い職場においては、採用段階で女性を弾いてしまうといった、本人の意思や能力で見られるところを性差で選別をしてしまうことで問題化した。また、宗教や人種差別をスコアリングに直接反映してしまう、または先の差別が間接的に関係する居住地域等をインプットデータにしてしまい、結果として融資額が低く見積もられる事例が発生した。この場合、逸失利益が発生することでAI倫理に関係する問題として認知された。

プライバシー侵害もヒトの精神的苦痛をもたらす可能性が大きく問題として挙げられる。2020年のBlack Lives Matter運動*5において、警察(法執行機関)によるデモ運動の監視に用いた顔認識技術の利用が問題化した。この問題は生体認識を通じたプライバシーの侵害による精神的苦痛のみならず、誤認逮捕による拘禁が伴えば、物理的(肉体的)苦痛を与えることにもなる。物理的苦痛の代表例は、自動運転やロボットの誤作動が挙げられよう。この際、AIによる損害の発生における責任の所在が問題となっている。

上記の通り、AIによる問題は、精神・経済・物理的な損害を複合的に与え得るのである。これらの問題は、AIシステムのモデルによって発生するのではなく、AIシステムの全体で発生しうる。

上述のようなAIシステムの問題の認知は、AIの利用拡大に伴い進み、複雑化しつつある。こうした事態に対して、国際機関や政府機関等によるガイドライン・規制の整備という流れと、プラットフォーマー企業によるAIガバナンス体制の構築や取り組みという流れが生じた。この流れは、互いに影響を与えており、AIガバナンスの進化が進んでいる。

次章では、それぞれの動きについて詳述する。

※1:Carl Benedikt Frey and Michael A. Osborne “THE FUTURE OF EMPLOYMENT: HOW SUSCEPTIBLE ARE JOBS TO COMPUTERISATION?”, University of Oxford, 2013

※2:AIの知性が人類の知性を超える技術的転換点、またはそれがもたらす世界の変化のこと

※3:総務省「平成28年版情報通信白書」(2022年9月28日閲覧)https://www.soumu.go.jp/johotsusintokei/whitepaper/ja/h28/pdf/n4200000.pdf

※4:顧客を属性情報や行動情報によって定量的に評価する手法

※5:アフリカ系アメリカ人のコミュニティに端を発した、黒人に対する暴力や構造的な人種差別撤廃を訴える、国際的な運動

AIガバナンスに係るガイドライン・規制の動向

前述のAIシステムがもたらした事件は、AI開発における倫理的な規範を求めることにつながった。

AIに関する規範めいた原則として想起されるもので著名なものは、米国のSF作家であるアイザック・アシモフが、ロボットシリーズといわれる一連の小説群の中で示されたロボット工学3原則が挙げられよう。同原則は、「人間への安全性、命令への服従、自己防衛」を目的とする3つの原則から構成されている。実際には、この3原則をロボットに適用するとフレーム問題*6を引き起こすと推測されている。

ロボット工学3原則は、ロボット工学にも影響を与えたとしているが、倫理的な問題を、特にビジネス遂行の観点で具体的な解決に寄与するものではない。現出する問題に対する倫理的な規範の嚆矢的なソフトローの代表例としては、非営利団体の「Future of Life」によるアシロマ原則が挙げられる。

同原則は、2017年1月、カリフォルニア州アシロマに、全世界から AI の研究者と経済学、法律、倫理、哲学の専門家が集まり、「人類にとって有益な AI とは何か」を5日間にわたって議論した成果として2017年2月3日に発表された。この原則は、AI の研究、倫理・価値観、将来的な問題の3つの分野に関して、研究開発のあり方、安全基準の遵守、透明性の確保、軍拡競争の防止、プライバシーと人格の尊重など、幅広い視点からの提言がなされている。

強制力はないものの、同原則には多くの支持者がついており、物理学者のスティーブン・ホーキング博士やイーロン・マスク氏や、シンギュラリティ大学の創設者のレイ・カーツワイル博士などの著名人も支持者に名を連ねている。2022年9月時点では、1,797人のAI/ロボティクス研究者と3,923人の研究者が同原則に署名している*7。

こうした学術団体などによる提言は、2017年以降に増加しており、Partnership on AI(PAI)といったグローバル企業が協賛する団体によるAI倫理を含む研究も推進されている。こうした先進的な研究成果が協賛するグローバル企業にもフィードバックされ、特に大手のプラットフォーマー企業を中心にAIガバナンスの体制形成・運用期に至ったと認識している。実際、2017年頃のAIガバナンス体制形成の動きは、トップダウンアプローチよりも、データサイエンティストを中心とした“下の根”活動が中心となり、AI倫理に関する重要度や認知を社内で醸成することで、正式な活動になったことが複数社より確認ができている。

企業によるAIガバナンスの先進的な取り組みは、プラクティスを生み、上述の団体などに共有され、研究対象としてさらにブラッシュアップされている構造が見えてくる。米国の米国電気電子学会 (Institute of Electrical and Electronics Engineers|以下、IEEE)では、2016年頃からガイダンス策定を行い、パブリックコメントの収集を通じ、ガイダンスの改訂が行われ、AI開発現場における有力なツールを提供している。

IEEEに関連する規格関係では、2017 年 10 月に、情報技術分野の標準化組織である ISO/IEC JTC1(Joint Technical Committee 1)に、AI にかかる国際標準を議論する SC42 が設置された。総会の開催など、AI の信頼性を含む様々なワーキンググループ(以下、WG)に分かれて、標準化の議論が進められている。

なお、日本では、情報処理学会内の情報規格調査会に SC42 専門委員会が設置され、国内の意見のとりまとめや国際的な対応をしている。このような活動の中、国立研究開発法人産業技術総合研究所(以下、産総研)は、AI の研究開発だけではなく、SC42 にかかる実質的な取り組みを推進している。SC42 は、AI のガバナンス、基礎的標準、データ、信頼性、ユースケースと応用、計算アプローチと計算的特徴の6つの WG にわかれており、そのうちの2つの WG のコンビナー(主査、とりまとめ役)を日本が確保している。

その他にも、AI マネジメント、ビッグデータの品質、AI ライフサイクルなどのアドホックグループが設置されている。信頼性確保のための AI の品質評価手法の議論は日本が先行しており、2020 年 6 月に公表された産総研の機械学習品質マネジメントガイドライン*8が、その標準化提案の基礎的成果に位置づけられている。

AI 標準の国内委員会は、ISO/IEC JTC1 の活動とは別に、EU の標準化団体であるCEN/CENELEC と協力関係を深めている。両者は、テーマを特定して、標準化の専門家同士で議論するとともに、2020 年 9 月には、政府の政策・標準担当者向けにワークショップ(EU-Japan Workshop on Trustworthy AI Standardization and R&D)を開催している。

上記のように、企業や非政府系の団体の相互作用が認められる中で、政府機関による検討および連携も見受けられる。日本においては、総務省がAIネットワーク検討会議(後にAI ネットワーク社会推進会議)を開催し、2017年には「AI開発ガイドライン案」*9が公開された。以降、総務省や経済産業省、内閣府などが、AI開発に関する各種のガイドラインが発行している。

内閣府は、経済発展と共に社会課題を解決する「Society5.0」の実現を目指し、実現にAIの果たす役割が大きく、AI原則を策定したが、策定には世界的な連携の下で進められている。この原則を策定した「人間中心のAI社会原則検討会議」*10は2018年4月に活動を開始したが、当初から欧米各国やOECDなどの海外政府機関との連携を視野に置き、日本が主体的にAI原則を作成し、その考え方を世界に広げることを目的に活動してきた。実際、G20による2019年のAI原則の制定・合意は、日本がAI原則を作成する過程で各国関係者と議論を積み重ねてきたことが大きく貢献したといわれている。

欧州では、2017年以降に欧州評議会や欧州委員会を中心にガイドライン整備を進めている。このように、AIに関するガイドラインは、各国間の連携によって進められてきており、今後も国際協調の中で、法制化に至ることが想定される。

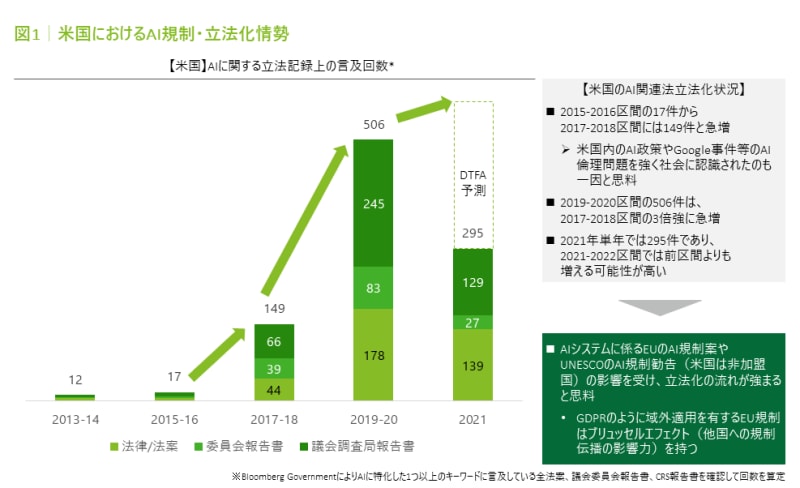

法制化の流れとして、米国においては、スタンフォード大学の調査によれば、AIに関する立法記録上の言及回数が2017~2018年から急激な増加が見られている*11。

また、国際的な法制化を加速させる出来事が、2021年に生じた。1つは、UNESCOによる「AI 倫理規範」の勧告案が可決されたことにある*12。

UNESCOは2021年の11月にAI倫理に関する国際的な規範を策定し、加盟国への「勧告」として総会で採択した。これはAIの倫理に関する国際的な初の合意となる。アズレ事務局長は記者会見で「AIは(人類の)共通利益に役立つが、分かりにくさや不透明さなどの問題がある」と指摘した。勧告に法的拘束力はないが、加盟国は法制化など「内容を履行する責任がある」とし、各国の取り組みをチェックし、評価する仕組みも盛り込んだと意義を訴えている。

そして、2つ目の大きな法制化の流れとしては、欧州のAI規制案*13の公開である。

本規制案は、2020年にAIの普及促進およびリスクへの対処に関する政策オプションを欧州委員会が提示した「AI白書」*14に対する法規制面のフォローアップ文書として2021年4月に公表している。

同規制案では、「AIシステム」の定義を、機械学習アプローチ、論理ベース/知識ベースアプローチ、統計的アプローチのいずれかの技術を使用し、人間が定めた目的のために、当該システムが相互作用する環境に影響をもたらすコンテンツ、予測/推奨/決定等のアウトプットを行うソフトウェアとしている。

上記の規制案の特徴として、いわゆる域外規制が掲げられている。この域外規制はEU一般データ保護規則 (General Data Protection Regulation|以下、GDPR)と同様で、より広範な国の事業者に強い影響を与えるものと考えられる。そして、本規制はGDPRよりも制裁が強められ、最大3,000万ユーロまたは世界全体売上高の6%のいずれか高い金額が制裁金として科される。GDPRの制裁金は最大2,000万ユーロまたは世界全体売上高の4%のいずれか高い金額であることから、1.5倍の制裁が科される可能性が存在する。

企業の規制の備えのスタンスとして、過去の経験(例えばGDPRへの対応)を踏まえると、規制の場当たり的な対応や、立法化された規制の文言対応に留まるスタンスは望ましくないと考える。規制上の問題をクリアできても、社会的な批判を受ける可能性(ex.AI 採用ツールなどの使用によるレピテーションリスク)やビジネスにAI を活用する開発・実装までのリードタイムが長期化する可能性も懸念される。

技術的な進歩による新たな問題の噴出や、文化などの違いによって生じる特性を踏まえ、AI倫理についてはより問題に踏み込んだ検討が必要と考える。このように規制がなぜ設定されるのか、といった背景を熟知した上で、規制案の動向を把握した予測型の取組みが重要であると考える。

また、AI倫理の問題は、自社だけにとどまらず他社を巻き込み業界全体で取り組むことが望ましいと考える。各社のプラクティスを結集し、業界特有のAI倫理の問題に取り組むことで、業界内のAIシステムに対するエンドユーザからの信頼獲得につながることが期待できる。

次章では、AIの急速な進化への対応とともに、グローバル環境下で、様々な価値観を持つサービス展開国の“コンテクスト”を理解しようとする、AIガバナンスの先進的な取り組みを実施する企業例を紹介する。

※6 情報処理能力に限りのあるAIでは、現実に起こりうる課題すべての中から

その課題に関係することだけを抽出し実行することが難しいという問題

※7 ASILOMAR AI PRINCIPLES https://futureoflife.org/2017/08/11/ai-principles/

(2022年9月28日閲覧)

※8 機械学習品質マネジメントガイドライン

https://www.aist.go.jp/aist_j/press_release/pr2020/pr20200630_2/pr20200630_2.html

(2022年9月28日閲覧)

※9 総務省「AI開発ガイドライン・AI利活用ガイドライン」

https://www.soumu.go.jp/iicp/research/results/ai-network.html

(2022年9月28日閲覧)

※10 内閣府 人間中心のAI社会原則検討会議https://www8.cao.go.jp/cstp/tyousakai/humanai/index.html

(2022年9月28日閲覧)

※11 Stanford University 「2021 Artificial Intelligence Index Report」

https://hai.stanford.edu/ai-index-2021

(2022年9月28日閲覧)

※12 UNESCO 「UNESCO member states adopt the first ever

global agreement on the Ethics of Artificial Intelligence」https://en.unesco.org/news/unesco-member-states-adopt-first-ever-global-agreement-ethics-artificial-intelligence

(2022年9月28日閲覧)

※13 欧州委員会 欧州AI規制案

https://eur-lex.europa.eu/legal-content/EN/TXT/?qid=1623335154975&uri=CELEX%3A52021PC0206

(2022年9月28日閲覧)

※14 欧州委員会 欧州AI白書

https://ec.europa.eu/info/sites/default/files/commission-white-paper-artificial-intelligence-feb2020_en.pdf

(2022年9月28日閲覧)

AIガバナンス体制構築企業の動向

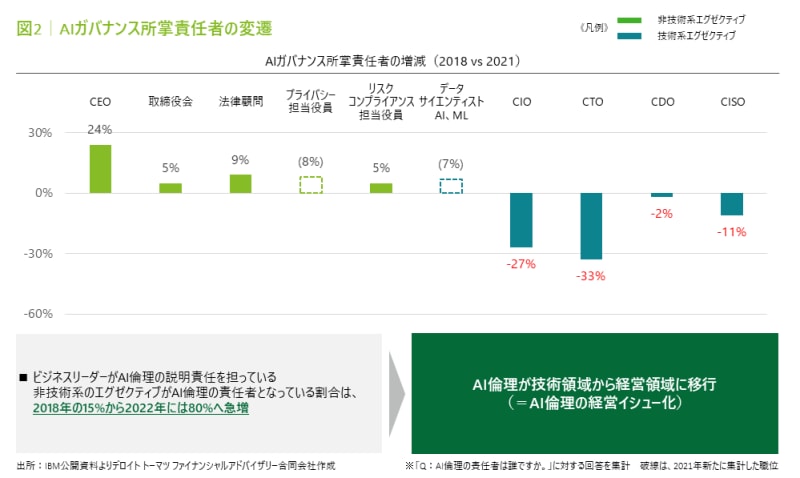

まずは図2を参照されたい。

前章で言及した通り、2017年以降にAIガバナンス体制の構築が目立った。その体制構築期(2018年)と2021年におけるAIガバナンス所掌責任者の増減について、IBMが興味深い研究結果を公表した*15。

IBMの調査によると、AI倫理の説明責任を担っている非技術系のエグゼクティブがAI倫理の責任者となっている割合は、2018年の15%から2022年には80%へ急増している。つまり、AIガバナンスを所掌する管理者層の代替わりが起きており、CEOが旗振り役を担うほどにAIガバナンスの重視姿勢が見て取れる。このことからAI倫理が技術領域から経営領域に移行し、AI倫理が経営イシューとして認知されたと考えられる。

こうした経営イシュー化の動きは、ガバナンス体制にも反映されている。例えば大手プラットフォーマーでは、下記の構造を採用している。

CEOの元、意思決定機能を有するチームを中核として、エンジニアを中心とするCommitteeがルール作成等支援している。また開発の現場に近い部門内ではAIモデルのレビューを行うチームが存在し、チェックリスト等作成、製品チェック等監査機能を有している。

AIエンジニアは、必ず倫理規定を知っているマネージャーの監視のもとで執務しており、エンジニアは、マネージャーが倫理規定を順守していないと感じた場合、意思決定機能を有するチームに通報可能(マネージャー経由でもエスカレーション可)としており、本社コーポレートによるガバナンスを利かせている。

また、AIの多様性を担保するため、ヒトの多様性も重視しており、外部アドバイザーとして女性や多国籍の方を招聘するといった行動もみられる。

この外部からの専門家人材を招聘して、外部委員会化する動きは国内企業でも見られる。

国内大手企業では、外部専門家による評価を受ける体制から徐々に内部組織を拡張し、2022年にはAI倫理ガバナンス用の部門を創設している。この同組織では、最先端テクノロジーの研究・開発・実装にまつわる倫理に関する国際的な動向、政策、法制度の動向等を踏まえ、AI倫理ガバナンスに関する全社的かつ総合的な取組みを強化する位置づけで設けられている。

同社では、AI倫理をコストではなく、付加価値として捉え、AI倫理を策定している。前章で述べたような機関から公開された様々なガイドラインを精査しつつ、かつ自社のパーパス(存在意義)をグループ倫理指針に落とし込む形でグループ倫理指針を策定している。

同社をはじめ、国内企業では2018年頃より各社のAI倫理ポリシーの公表が進んでいる。

※15 IBM「IBM調査:AI倫理の責任は、IT部門からより経営幹部層全般に移行」

https://jp.newsroom.ibm.com/2022-06-08-Responsibility-for-AI-Ethics-Shifts-from-Tech-Silo-to-Broader-Executive-Champions,-says-IBM-Study

(2022年9月28日閲覧)

AIガバナンスのあるべき姿

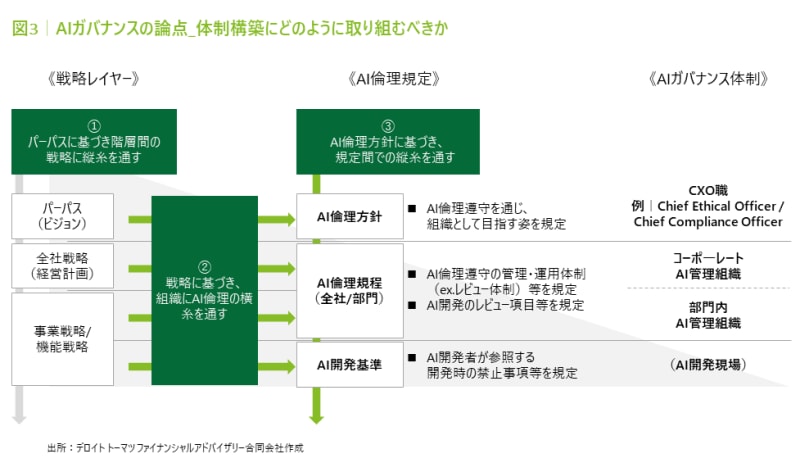

AIガバナンス体制を敷くにあたっては、単なる外部規定の引用ではなく、会社に適合させる必要がある。これは取り扱うAIによって生じるリスクが異なることや、展開先国等の違いにもよって大きく左右されるためでもある。

そのため、自社のパーパスに基づき階層間の戦略に縦糸を通している(整合性が取れている)ことを前提に、各階層間の戦略に沿ったAI倫理の規定および組織体制を構築する必要がある。特に規定の策定に際しては、規定全体での整合性が取れる必要がある。

この図では、あくまで標準的なモデルであり、必ずしも各階層に規定や組織を置く必要はない。管理コストと実効性のバランスを考慮する必要があり、こうした知見は他社動向などを調査して参考にするのも有益である。

このAIガバナンスの構築は、先々の運用を当然ながら見据えて設計することが望ましい。単なる規定や体制整備にとどまるのではなく、AIガバナンスの運用ループを回すことが重要と考える。

AI技術の進歩は早く、また、規制の変化もあり、一度定めた規定を金科玉条のごとく扱うのは危険であると考える。知見収集を行いつつ、外部環境もモニタリングしながら、常に改訂の余地がないかを探ることが必須と考える。

AI倫理から生じるAIガバナンスは、もはや喫緊の経営課題として認知されるべきと考える。先の欧州AI規制案が立法化され、適合性評価が求められる段階で“知らなかった、不意打ちだ”とならないように、動き出す必要がある。ただし、AI規制がヒトの苦痛を取り除き、AIのメリットを最大限享受する理念に基づいて検討されているように、AIサービスを提供する企業が、この取組に目を背けることは、真にクライアントと相対することに目を背けることと同義であるという意識をもって、国内企業の検討が盛り上がることが重要ととらえている。

執筆者

デロイト トーマツ ファイナンシャルアドバイザリー合同会社

知的財産アドバイザリー

シニアアナリスト 濱田 智久

監修

デロイト トーマツ ファイナンシャルアドバイザリー合同会社

知的財産アドバイザリー

パートナー 國光 健一

(2022.11.1)

※上記の社名・役職・内容等は、掲載日時点のものとなります。